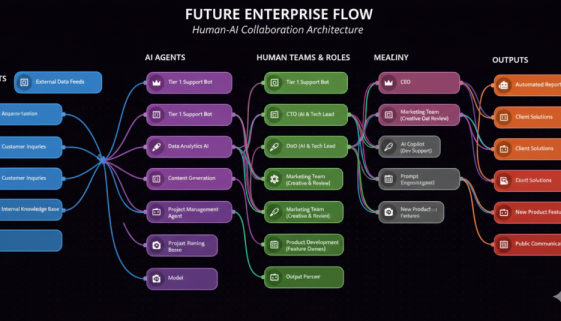

El organigrama de tu empresa se parecerá más a una arquitectura de software que a una jerarquía de personas.

Hace unos días escribí que el éxito empresarial en 2026 no se mediría por la inversión en tecnología sino por la capacidad de repensar la arquitectura del trabajo. ¿Qué significa exactamente esto, y por qué tienes menos tiempo del que crees para resolverlo?

La contradicción es clara, las empresas empiezan a tener agentes de IA que desarrollan parcialmente algunas tareas de sus procesos o workflows, pero éstos no aparecen en el organigrama empresarial. Es cierto que son pocas las empresas que ya usan algún tipo de agente, también es cierto que estos agentes a día de hoy son muy, muy sencillos a modo de GPTs o Gemas, pero esto no ha hecho más que empezar, y por la carga de trabajo que ya llevo, esto va ir muy rápido. La unidad de medida ya no será la persona, será la tarea.

Jerarquía y arquitectura no son lo mismo

El organigrama responde a una pregunta: ¿Quién manda sobre quién? Es un mapa de autoridad. Útil para gestionar personas, resolver conflictos de competencia, establecer líneas de responsabilidad. Lo que no hace el organigrama es describir cómo fluye el trabajo: qué input necesita cada proceso, qué output produce, dónde está el cuello de botella, qué nodo falla cuando hay un problema.

Eso lo describe la arquitectura.

En el mundo del software llevan años pensando así. Cuando diseñas un sistema no preguntas quién reporta a quién: preguntas qué componente recibe este evento, qué servicio transforma estos datos, dónde se introduce criterio humano, qué pasa cuando falla un nodo.

Hasta ahora, una empresa podía confundir jerarquía con arquitectura porque el trabajo lo hacían personas, y las personas tienen jefes. Cuando parte del trabajo lo ejecutan agentes — y ya lo empiezan a hacer — el organigrama no representa el flujo de trabajo real. Los agentes no tienen jefe. Tienen diseño. Y si nadie ha diseñado explícitamente cómo operan, lo harán como alguien lo desarrolló sin pensar en nada más.

Cuatro conceptos que son decisiones reales, no tecnicismos

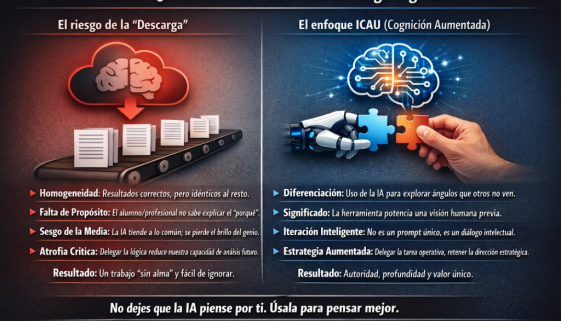

Hay una gramática mínima que cualquier directivo/manager/responsable necesita manejar hoy. No para programar. Para tomar decisiones de diseño sobre su propio negocio.

Orquestador y ejecutor. En cualquier workflow con agentes hay dos roles: el que descompone el objetivo en tareas y las asigna, y el que las ejecuta. Pueden ser humanos, agentes o combinaciones. La pregunta que importa no es “¿usamos IA?”, sino “¿En qué parte de este proceso hay un humano y qué aporta que un agente no puede?” Esa pregunta obliga a pensar en arquitectura.

Human-in-the-loop. No es supervisión, es una decisión de diseño con consecuencias reales en velocidad, coste y tipo de errores que asumes. Dónde introduces al humano determina qué puede fallar y con qué impacto. Una empresa que no ha tomado esa decisión explícitamente la ha tomado por inercia, y casi siempre mal.

El nodo humano mal asignado. Una persona cualificada dedicando horas semanales a consolidar datos, formatear informes o gestionar tareas repetibles es un cuello de botella invisible. El coste no es solo económico. En mi artículo anterior sobre el desplazamiento del valor humano, describí cómo la ejecución repetible no debería ser territorio humano. Aquí está el mecanismo organizacional de ese argumento: cada nodo humano mal asignado es deuda cognitiva acumulada. Capacidad de juicio, criterio y pensamiento estratégico que se consume en trabajo que no lo requiere.

El fallback. Qué pasa cuando el proceso falla, cuando el agente encuentra un caso que no sabe resolver, cuando el input es inesperado. Las empresas que no diseñan el fallback tienen siempre el mismo por defecto: alguien llama a alguien y lo resuelve a mano. Eso no es resiliencia. Es improvisación.

Por qué 2028 y no “algún día”

Esta semana Perplexity lanzó Computer: un sistema que toma un objetivo, lo descompone en subtareas y las ejecuta en paralelo durante horas usando agentes especializados, sin intervención humana continua. Anthropic adquirió Vercept, una startup que había construido un agente capaz de operar un ordenador en la nube como lo haría una persona. Google tiene Project Mariner ejecutando tareas en la web de forma autónoma. Estos sistemas no son demos. Son productos disponibles con suscripción.

La curva de adopción en empresa mediana desde que la tecnología está disponible para early adopters hasta que se convierte en estándar operativo es de 18 a 24 meses. Estamos en ese punto de partida ahora mismo. La tecnología ya la tenemos, en breve todo será distinto.

Eso sitúa el margen temporal en 2027-2028. No como predicción futurista sino como extrapolación de lo que ya está en marcha. La pregunta no es si ocurrirá. Es si tu empresa llegará a ese momento habiendo diseñado su arquitectura de trabajo, o habiéndola dejado crecer sola.

La pregunta con la que trabajo con mis clientes

No termino con una lista de recomendaciones. Termino con la pregunta que uso al inicio de cualquier proceso de rediseño:

Si tuvieras que construir tu empresa desde cero hoy — con agentes disponibles, con los sistemas que existen en este momento — ¿qué seguiría haciendo un humano y por qué?

La respuesta no es “nada”: el criterio, la responsabilidad y la creatividad estratégica siguen siendo territorio humano. La respuesta tampoco es “todo lo que hacemos ahora”: eso es el organigrama respondiendo cuando debería responder la arquitectura.

La respuesta está en el medio. Y encontrarla, de forma rigurosa y con método, es exactamente el trabajo que las empresas necesitan hacer en los próximos 18 meses.

En el siguiente artículo responderé a esa pregunta con un caso concreto.

Seguimos adelante!!!